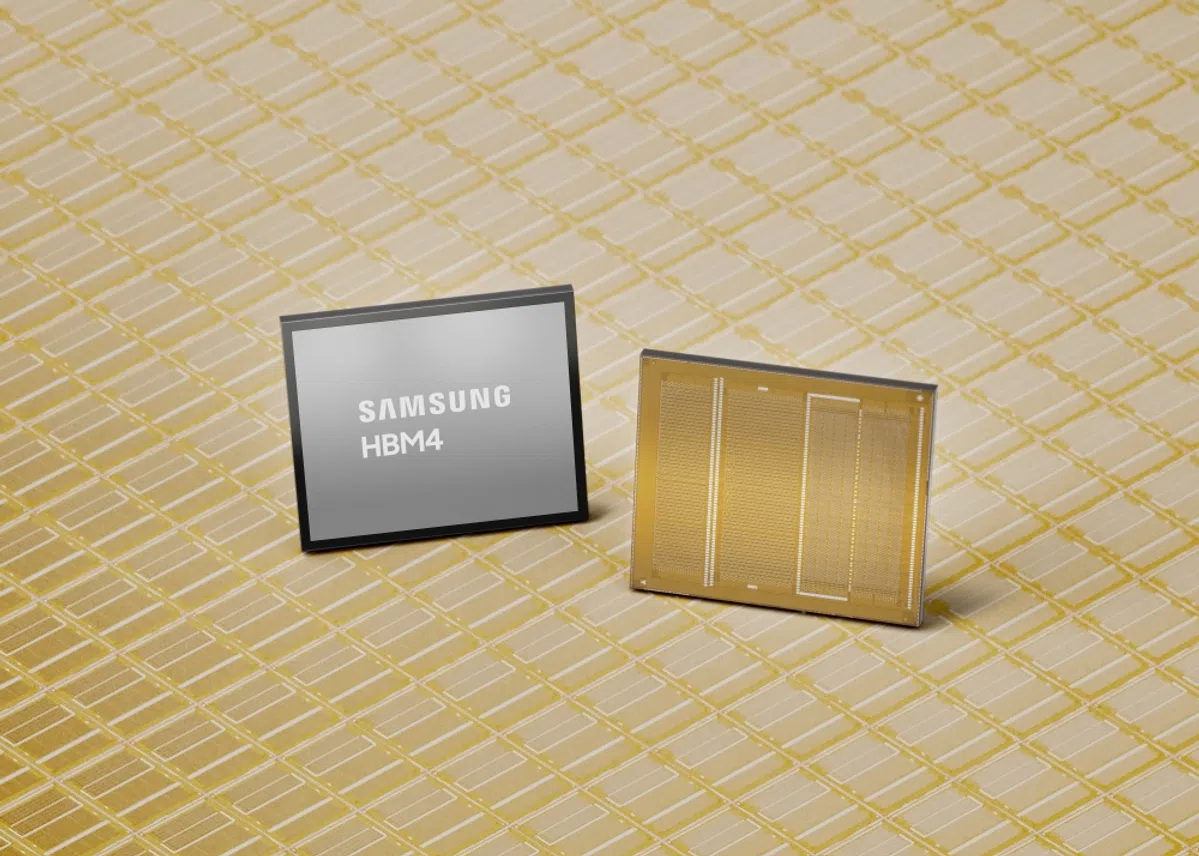

Samsung is begonnen met de massaproductie van een gloednieuwe generatie geheugenchips die speciaal zijn ontworpen voor kunstmatige intelligentie. Het gaat om de zogeheten HBM4-chip. Samsung is daarmee de eerste chipmaker ter wereld die zo ver is.

AI-systemen zoals ChatGPT draaien in enorme datacenters vol servers. Die servers hebben niet alleen rekenkracht nodig, maar ook supersnelle geheugenchips die razendsnel grote hoeveelheden data kunnen aanleveren. Een goede manier om het visueel voor te stellen is een snelweg: hoe meer rijstroken er zijn, hoe meer verkeer er tegelijk doorheen kan. HBM-chips (high-bandwidth memory) zijn zeg maar de breedste snelwegen die er bestaan in de chipwereld.

De nieuwe HBM4-chip van Samsung haalt een verwerkingssnelheid van 11,7 gigabit per seconde, met pieken tot 13 gigabit per seconde. Dat is zo’n 46 procent sneller dan de huidige industriestandaard van 8 gigabit per seconde en volgens het bedrijf ruim 22 procent sneller dan de vorige generatie HBM3E-chips. Dat betekent in de praktijk dat AI-systemen complexere taken aankunnen zonder dat het geheugen een bottleneck wordt.

Race met SK hynix

De eerste chips zijn al geleverd aan klanten. Samsung noemt geen namen, maar het is een publiek geheim dat Nvidia, het Amerikaanse bedrijf dat de processors maakt waarop vrijwel alle AI-systemen draaien, een van de grootste afnemers is. Nvidia heeft een haast onverzadigbare honger naar dit soort geheugenchips.

Het Zuid-Koreaanse bedrijf is verwikkeld in een felle concurrentiestrijd met landgenoot SK hynix, dat ook een grote speler is op de markt voor high-performance geheugenchips. Beide bedrijven wilden als eerste met HBM4 komen en Samsung claimt nu die race gewonnen te hebben. Het aandeel van Samsung is vanochtend dan ook met zes procent gestegen op de beurs in Seoel.